Il "DVD 2.0" entro Natale

Toshiba è intenzionata a preparare una nuova offensiva contro il Blu-ray, confermando la prossima uscita di lettori DVD 2.0 dotati di maggiore risoluzione, processore CELL, interattività e costi allettanti

Poco meno di due mesi fa vi riportavamo un'indiscrezione secondo cui Toshiba, in collaborazione con Microsoft e Panasonic, stesse mettendo a punto una versione evoluta del classico DVD (vedi news). Sulle pagine del quotidiano nipponico Yomiuri Shimbun un portavoce Toshiba ha confermato lo sviluppo della nuova piattaforma, anche se rimane ancora il massimo riserbo sulle specifiche tecniche di ciò che possiamo definire "DVD 2.0".

In buona sostanza, Toshiba dichiara che i nuovi media assicureranno una qualità delle immagini molto simile a quella offerta da Blu-ray e HD DVD e che i nuovi lettori saranno retrocompatibili con i tradizionali DVD. Come vi avevamo già annunciato, i DVD 2.0 (rimaniamo in attesa di conoscere il vero nome commerciale) erediteranno dall'ormai defunto HD DVD le funzionalità interattive HDi, nonché quelle di collegamento via web.

Alla base del nuovo standard ci sarebbe l'implementazione del processore CELL in versione semplificata (4 core, in luogo degli 8 utilizzati sulla PS3) SpursEngine che assicurerà la decodifica dei dischi DVD 2.0, ma anche l'upscaling dei tradizionali DVD fino a 1080p. Toshiba avrebbe, infine, preparato una piattaforma per consentire alle case cinematografiche di "convertire" facilmente gli attuali cataloghi DVD al formato 2.0 (tramite upscaling del materiale standard definition?)

Toshiba sottolinea, infine, che il DVD 2.0 avrà costi produttivi di poco superiori a quelli attuali del DVD e che i nuovi lettori saranno venduti a prezzi decisamente inferiori a quelli degli attuali Blu-ray. I primi modelli dovrebbero essere commercializzati entro i prossimi 6 mesi (quindi in tempo per le feste natalizie). Attendiamo a questo punto caratteristiche tecniche più specifiche...

Fonte: VNunet

Commenti (149)

-

Se questo DVD 2.0 arriverà a Natale (e molto probabilmente partirà dagli USA quindi ora che arriva di qua stiamo freschi...) il BR avrà già fatto suo un buon 10 % di mercato (visto che ora si attesta sui 6-7 %) ed è IMHO una quota che gli da una certa sicurezza a livello di longevità...secondo me vi preoccupate eccessivamente di un prodotto che vuole solo essere un evoluzione del DVD e che si posiziona come qualità fra DVD e BR....

-

Per curiosità, dov'è la notizia che dietro ci sia Microsoft? sono curioso di leggerla.

-

Originariamente inviato da: PicanderSe una scena è parzialmente in movimento casca tutto.

E perché mai?

La compressione MPEG2, come quella di qualunque altro codec video, si basa su un analisi sequenziale dei fotogrammi prendendo come riferimento i keyframes, cioè fotogrammi chiave che vengono analizzati per intero, sulla base dei quali vengono eliminati le parti che non subiscono modifiche nei frame intermedi.

In pratica, fra un keyframe e l'altro vengono considerati solo le zone che si muovono, cambiano di colore o luminosità o che comunque cambiano in qualche modo, tutto il resto non viene considerato.

Questo processo di quantizzazione richiede l'interpretazione di un pattern più o meno esteso di frame a seconda del tipo di compensazione scelto.

I pattern considerati contengono tre tipi di frames: Intraframes (I Frames, codificati direttamente cioè i keyframes); Forward Predicted Frames (P Frames, codificati sulla presunzione del I Frame precedente) ed i Bidirectional Frames (B frames, codificati sulla base del I Frame precedente e del P Frame seguente).

[IMG]http://www.crs4.it/Multimedia_Reports/mpeg_figs/fig1.gif[/IMG]

Questo è un pattern IBBPIBBP, ma se ne possono segliere di molto più complessi.

Chi usa un software di compressione MPEG, avrà già visto sequenze simili.

Il discorso è un po' complesso, per chi è interessato leggere qui, capitoli Motion Compensation e Stadi di trasformazione: Quantizzazione

Quindi credo sia tutt'altro che impossibile inserire un ulteriore processo di analisi su 9 frame, come riportato da Gattapuffina, per ottenere un maggiore microcontrasto ed un migliore upscale.

Quello che serve è la potenza di calcolo necessaria per effettuare tutte queste operazioni in real time.

Ciao.

Altre info: http://www.avmagazine.it/forum/show...mp;postcount=16 -

Non servono neanche software specifici, basta Photoshop:

Quello che fa Photoshop è molto più semplice, infatti l'operazione è piuttosto veloce. Prova a scaricare la demo di PhotoAcute (io, ovviamente, l'ho fatto, per capire di cosa si parla), e guarda i tempi di elaborazione a confronto di Photoshop, e guarda i risultati. Non c'è paragone. Per questo ci vuole un Cell + hardware dedicato.

Il bicubico di PS è un algoritmo molto semplice. Non conosco questo Photo Acute né su quali algoritmi si basi, ma per mia esperienza lo S-Spline è fra i migliori, se non il migliore.

L' S-Spline è comunque un algoritmo di ingrandimento che è solo 2D, si applica alla singola immagine, PhotoAcute usa un sistema che in principio è molto simile a quello di Toshiba, perchè usa la sequenza per estrarre informazioni utili all'upscaling. I risultati sono chiaramente visibili, ripeto, prova a scaricare la demo, e vedi se riesci con qualsiasi altro algoritmo ad ottenere la stessa qualità.

Non mi pare proprio che gli esempi fatti con S-Spline che hai postato portino ad un risultato anche minimamente paragonabile a questi:

http://www.photoacute.com/studio/ex...3yes/index.html

Ah, tra l'altro, S-Spline è molto adatto ad ottenere ingrandimenti estremi, se fai caso, sia PhotoAcute, nella modalità che aumenta la risoluzione, sia la Toshiba (che parla di 960p), fanno un upscaling *esattamente* 2x. -

Girmi, non stiamo parlando di migliorare la compressione. Stiamo parlando di ottenere un'immagine qualitativamente migliore dell'originale!

L'ottimizzazione dell'immagine è stata ottenuta con l'invenzione dell'mpeg4.

Ripeto, una serie di scatti fotografici sono un conto... un filmato un altro. -

Originariamente inviato da: PicanderRipeto, una serie di scatti fotografici sono un conto... un filmato un altro.

No, è solo più complicato, ma è certamente possibile.

A parte che lo stesso PhotoAcute (che comunque non è nato per il video), permette di aprire anche un gruppo di fotogrammi da un video, è possibile fare un'analisi di gruppi di fotogrammi (per il sistema Toshiba si parla di gruppi di 9), ed è anche fattibile un analisi di cosa si muove e cosa no.

E' solo computazionalmente MOLTO pesante, per questo ci vuole un chip dedicato di nuovo tipo, con aggiunta del Cell che, incidentalmente, è molto adatto per questo tipo di calcoli.

E comunque, facevo l'esempio del PhotoAcute perchè, essendoci la Demo, chiunque può provare a vedere come funziona, ma questa schermata:

http://www.watch.impress.co.jp/av/d...114/dg96_14.jpg

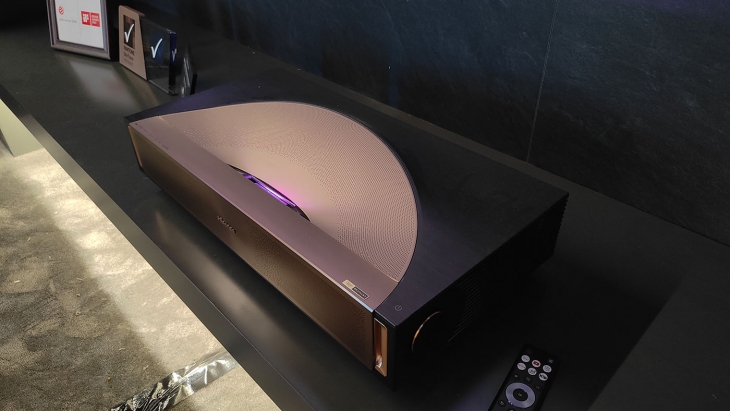

E' proprio del sistema della Toshiba, ed è presa da un video. Ed è stato già mostrato dal vivo in una fiera, vedi qui: (la foto non è un granchè, ma si capisce l'aumento di risoluzione)

http://www.blogsmithmedia.com/www.e..._0562_small.jpg -

Ma secondo te l'originale è quella di sx o quella di dx?

Comunque se questo è il risultato è sicuramente interessante! -

Trovati altri screenshot:

http://www.audioholics.com/educatio...video-processor

E anche qualche video:

http://www.wisdom.weizmann.ac.il/~v...rRes_demos.html -

Comunque per riportare il tutto su toni meno focosi e piu' chiari (visto che mi dispiace di essere dipinto in certi modi distanti da me

) ribadisco chiarendo la mia posizione vista aprioristicamente critica da molti di voi:

) ribadisco chiarendo la mia posizione vista aprioristicamente critica da molti di voi:

Le idee sull'upscaling e la spinta al massimo di nuovi sistemi mi interessano parecchio, giusto d'esempio puo' esserci il fatto che ho una grossa collezione di dvd e che a brevissimo striscerò dal plafond della mia carta circa 400 euro per il nuovo Oppo983

La mia acrimonia è per la storia dei dischi con questa proposta del 960p.

Quindi sul lavoro che Toshiba e partner faranno per scrivere specifiche e algoritmi per il cell sono interessato, poi...dei nuovi film in 960 invece non parlatemene ... ehm ...

... ehm ...