HDR: metadati statici vs dinamici

Quali sono i vantaggi del poter contare su un flusso di metadati dinamici, legato alle curve del gamma di tipo HDR e cosa succederà nei prossimi mesi tra Dolby Vision e il nuovo standard HDR10+?

Una delle notizie più interessanti arrivate con l'edizione 2017 dell'IFA di Berlino riguarda la nascita di una associazione tra Samsung, Panasonic e 20th Century Fox per la standardizzazione e il rilascio di licenze per un nuovo formato HDR basato su dati dinamici, retro-compatibile con l'attuale sistema con dati statici e molto più economico rispetto al sistema già standardizzato da Dolby, chiamato Dolby Vision e già adottato - quest'ultimo - da alcuni costruttori di TV e disponibile in streaming e su supporto fisico.

Prima di parlare dei vantaggi dei formati HDR con dati dinamici, serve una premessa sullo standard HDR con dati statici. Ebbene, nella preparazione dei contenuti, coloro che effettuano la color correction lavorano oggi su monitor con parametri che riguardano gamut, rapporto di contrasto e capacità dinamiche, ben definiti. Ad esempio, il monitor più utilizzato nel mastering HDR è il modello Sony BVM-X300V2 con tecnologia OLED, risoluzione 4K, 10 bit per componente, diagonale di 30" e picco di luminanza di 1.000 NIT.

Oltre al Sony esistono anche i monitor Dolby PRM-4220 con tecnologia LCD e local dimming con migliaia di zone, 12 bit per componente e picco di luminanza che arriva fino a 4.000 NIT nella versione "Pulsar" con pannello raffreddato a liquido. In tutti i casi, durante la color correction, il colorist provvede a formattare le immagini osservandole attraverso uno di quei monitor che hanno un rapporto di contrasto elevatissimo, un gamut colore che ha almeno le dimensioni di quello DCI-P3 e un picco di luminanza che di solito prevede 1.000 NIT ma che in alcuni casi arriva fino a 4.000 NIT.

Una volta preparato il flusso video, per la creazione delle immagini in HDR10 vengono creati anche i metadati statici che prevedono alcune infomazioni indispensabili e sono di tre tipi: 1- SMPTE ST.2086 del volume colore del mastering display utilizzato (gamut, punto del bianco, luminanza minima e massima); 2- MaxFALL (Maximum Frame Average Light Level - luminanza media massima dei fotogrammi dell'intero contenuto, escluse le eventuali bande nere); 3- MaxCLL (Maximum Content Light Level - il livello di luminanza massimo del pixel più luminoso dell'intero contenuto).

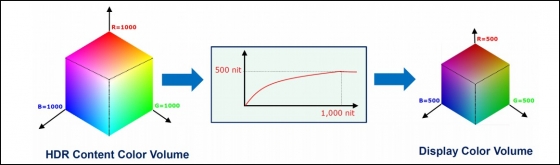

Questi tre tipi di metadati, possono essere inseriti all'interno del flusso video HEVC e anche nell'InfoFrame della connessione HDMI. Sono dati indispensabili, che vengono utilizzati dall'elettronica del TV/monitor/proiettore usato per riprodurre il flusso video HDR10. La necessità deriva dalla distanza - a volte anche "siderale" - che c'è tra il monitor usato per il mastering e quello usato per riprodurre i contenuti. Il problema infatti è che oggi, nel settore consumer, non esiste un display che sia simile per caratteristiche ai monitor Sony e Dolby usati dalla stragrande maggioranza di colorist per la preparazione dei contenuti HDR.

Anche tra i migliori TV OLED in commercio, il gamut è comunque più ristretto e il picco di luminanza massimo difficilmente supera i 700 NIT; in più, quando l'area dell'immagine luminosa cresce in dimensioni, il livello di luminanza scende ulteriormente, fino a meno di 300 NIT nei casi peggiori. Per i migliori TV LCD con retroilluminazione "Quantum Dot", che invece hanno un gamut ormai quasi sovrapponibile a quello dei monitor per il mastering e un picco di luminanza che in alcuni casi arriva anche a 2.000 NIT (es. Samsung Q9), c'è il problema del rapporto di contrasto nativo non particolarmente elevato (max 6.000:1) perché il livello del nero non è abbastanza contenuto e il local dimming non è ancora in grado di fare miracoli. Questo limite genera anche un restringimento del gamut nei primi gradini di luminosità.

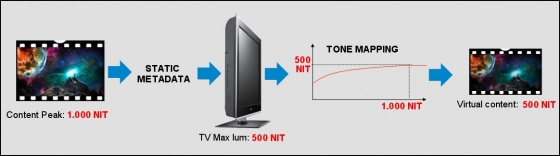

In poche parole, visto che anche i migliori TV in commercio hanno dei limiti, i costruttori operano un adattamento sul segnale video in modo da adattarlo il più possibile al pannello, operando quello che nel gergo tecnico viene definito "Tone Mapping". Orbene per operare il "Tone Mapping" vengono utilizzati i metadati statici, quindi ST.2086, MaxFALL e MaxCLL che però non cambiano per tutta la durata del contenuto. Più il display avrà caratteristiche lontane dal monitor usato per il mastering e più avrà difficioltà a raggiungere la luminanza media e massima del contenuto da riprodurre, più saranno necessari compromessi e più sarà pesante il "Tone Mapping". Vi lascio immaginare quali siano i compromessi necessari per un "cosiddetto" TV 4K HDR dotato di pannello LCD di tipo IPS, con luminanza che non raggiunge i 400 NIT e rapporto di contrasto nativo che non arriva neanche a 800:1.

Se invece i metadati potessero cambiare scena dopo scena, e magari ci fosse anche qualche informazione in più sulla metrica di luminanza, contrasto, APL e colore, l'elettronica del TV avrebbe più informazioni per poter operare un adattamento più efficiente e variabile nel tempo. Questo è il vantaggio dei metadati dinamici, che già può essere sfruttato in una catena di riproduzione che adotti lo standard Dolby Vision.

Il nuovo standard HDR10+, annunciato con la partnership tra Samsung, Panasonic e 20th Century Fox e di cui vi abbiamo parlato in questo articolo , promette gli stessi vantaggi del sistema concorrente Dolby Vision, a un costo sensibilmente inferiore per le aziende coinvolte nella produzione sia dei contenuti che dei TV, monitor e videoproiettori. Inoltre, per i motivi che ho esposto qui in alto, i TV che avranno più vantaggio dai metadati dinamici saranno quelli più economici, quindi più "distanti" come qualità e caratteristiche dai monitor usati per il mastering. Per essere ancora più chiari, un ottimo TV con picco di luminanza vicino a 1.000 NIT, gamut esteso e ottimo rapporto di contrasto, potrebbe avere vantaggi dall'introduzione dei metadati dinamici solo limitati e solo per contenuti caratterizzati da MaxFALL e MaxCLL particolarmente elevati.

Aggiungo anche che alcuni produttori già operano una sorta di "Tone Mapping" dinamico, analizzando il flusso video con tecniche simili a quelle già utilizzate per la gestione del local dimming o dei diaframmi dinamici dei videoproiettori ma che non sono sempre affidabili al 100%. Quando invece ci sono i metadati che sono il risultato di analisi molto più complesse che sono state effettuate "off-line" su ogni fotogramma, il vantaggio in termini di qualità d'immagine potrebbe essere molto evidente, soprattutto nei TV di fascia più bassa che non sono dotati di DSP efficienti, in grado di operare analisi in tempo reale sulle immagini.

Commenti (25)

-

14 Dicembre 2018, 14:29

HDR: metadati statici vs dinamici

Perfetto grazie...

vedo che solo con il croma 4:4:4 si richiede più banda passante per la gestione HDR.

Forse sto incominciando a capire qualcosa... :)

Fabio -

15 Dicembre 2018, 02:40

HDR: metadati statici vs dinamici

Si, da notare a frame rate di 23,976 passando da sottocampionamento chroma 4:2:0 a 4:2:2 il data rate rimane invariato, salendo di frequenza a 60, il passaggio da 4:2.0 a 4:2:2 il data rate aumenti. -

15 Dicembre 2018, 12:34

HDR: metadati statici vs dinamici

Pensi ci sia un motivo? Il fatto che ci sia bisogno di più banda avvalorava il fatyo di una effetiva gestione dei metadati. Forse nel 4:2:2 i dati sono compressi con più informazioni?

Boh

Fabio -

16 Dicembre 2018, 16:08

HDR: metadati statici vs dinamici

Nel subsampling chroma 4:2:2 Y' Cb Cr, i due campioni di crominanza (CbCr) sono campionati alla metà della risoluzione della luminanza (Y), dimezzando la risoluzione cromatica. Questo riduce la banda del segnale video di un terzo senza quasi perdite percettibili.

Probabilmente al salire del framerate aumentano le informazioni, con conseguente aumento di banda. -

16 Dicembre 2018, 23:43

HDR: metadati statici vs dinamiciOriginariamente inviato da: Nidios, post: 4920358, member: 443Come hai detto, è irrisoria. La porzione dei metadati è trascurabile rispetto alla banda dedicata a immagine e audio.Domandina forse ingenua,

il flusso di metadati che avviene fotogramma per fotogramma sull'HDR10+ quanta banda passante prende in bitrate?

Il fatto che ad alcune risoluzioni e frame-rate, ad 8 bit la banda richiesta sia sempre di 8,91 Gbps, dipende dalla struttura del segnale video e dal numero di pixel "inattivi" che vengono comunque trasmessi.

Sul sito Kramer, nel bitrate calculator, vengono indicati pixel attivi e totali nel segnale video ed è molto utile:

https://k.kramerav.com/support/bwcalculator.asp

Invece, in linea di massima, passando da 8 a 10 bit c'è un aumento di bitrate del 25%. Passando da 10 a 12 bit, si sale del 20%. Passando da 8 a 12 bit, c'è un aumento del 50%.

Emidio