stefanelli73

Active member

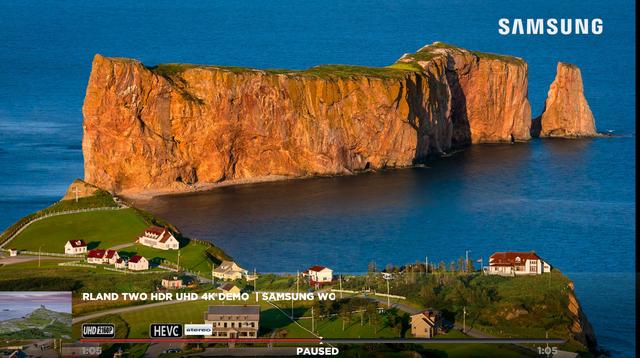

Spero che Madshi decida di intervenire sui colori,specie sul rosso che è diventato troppo saturo nelle ultime build.

Marco perdonami questa cosa l'avete notata sia su OPTOMA che JVC giusto?

Segui il video qui sotto per vedere come installare il nostro sito come web app sulla tua schermata principale.

Nota: Questa funzionalità potrebbe non essere disponibile in alcuni browser.

Spero che Madshi decida di intervenire sui colori,specie sul rosso che è diventato troppo saturo nelle ultime build.

Antonio,io lo riscontro un pochino anche in altri film;naturalmente non come in quelli elencati da te ma qualche "traccia"di rosso in più del dovuto permane sempre e dipende molto dalla scena