|

HDR e metadati: analisi preliminare sul Dolby Vision 2

Emidio Frattaroli - 16 Settembre 2025

|

|

C'era una volta il Dolby Vision...

Ero al CEATEC, in Giappone, nel lontano 2007, quando sentii parlare per la prima volta del Dolby Vision. Eppure abbiamo dovuto aspettare quasi 10 anni per poter riprodurre il primo Blu-ray Disc 4K con un Oppo UDP-203, per saggiarne parte delle possibilità. Senza considerare che ho dovuto aspettare altri 7 anni per trovare una catena completa (software, lettore e display) che potesse sfruttarne finalmente buona parte delle potenzialità. Nel frattempo non c'è dubbio che il marketing attorno al Dolby Vision sia stato potentissimo, anche se sembrano davvero pochi quelli che dimostrano di aver capito quali sono i potenziali vantaggi e come sia possibile sfruttarli, ad iniziare dalla dinamica completa del segnale video ai metadati dinamici che vengono inclusi nel flusso dati dai creatori dei contenuti e che dovrebbero permettere a TV e proiettori di migliorare la visione dei contenuti HDR.

Lo scorso 2 settembre 2025, tre giorni prima dell'inizio dell'IFA, esplode la bomba che nessuno si aspettava: Dolby Laboratories annuncia il Dolby Vision 2, una evoluzione del primo sistema di cui si è parlato per la prima volta nel 2007, annunciato in pompa magna nel 2014 ma introdotto realmente solo nella metà del 2017. Ebbene, dopo la pubblicazione della news, ho letto orgogliosamente e con molta attenzione tutti i commenti alla novità del Dolby Vision 2 sul nostro forum di discussione. E sottolineo "orgogliosamente" perché qui in redazione abbiamo tutti condiviso buona parte delle perplessità e abbiamo sorriso alla 'sottile' ironia di qualche battuta. Un sistema che non sarebbe compatibile con gli attuali dischi UHD Blu-ray 4K e i pochi lettori che rimangono. Ecco perché ho deciso di affrontare direttamente la questione grazie all'ospitalità di Dolby, presente ad IFA con una sessione di approfondimento e con massima disponibilità a rispondere a qualsiasi mia domanda.

Prima di arrivare al nocciolo della questione, secondo me è necessaria una "piccola" premessa, con l'obiettivo di fare un breve ripasso, utile a fornire anche a chi non padroneggia al meglio questi argomenti, tutti gli elementi essenziali per comprendere le mie considerazioni finali. Vi anticipo che in fondo a questo articolo troverete anche link ad articoli che potrebbero aiutarvi ad approfondire alcuni degli argomenti chiave che, per comprensibili motivi, non mi è stato possibile espandere. Buona lettura!

SOMMARIO

- C'era una volta il Dolby Vision...

- Qualità video: segnali SDR vs. HDR

- La compressione della gamma dinamica

- Con il video SDR tutto è relativo

- La gamma dinamica HDR

- Il Tone Mapping con metadati statici

- Metadati dinamici e processori video dedicati

- Tutte le novità del Dolby Vision 2

- Image Engine, Precision Black e Light Sense 2

- Intensity Control e Sport Optimization

- Authentic Motion e Pro Mode

- Conclusioni

Qualità video: segnali SDR vs. HDR

La qualità della riproduzione dei contenuti prettamente video, sia televisivi che cinematografici, è il risultato di un mix di concause che iniziano prima di tutto con la qualità originale del materiale prima della sua trasmissione (intesa come risoluzione, colori, dinamica, numero di sfumature e tanto altro ancora), che sia via etere, via streaming o da supporto fisico. Poi c'è la qualità della trasmissione e le dimensioni della banda passante (alias bit-rate) e infine ci sono gli ultimi tre step: la qualità del display, dell'ambiente e anche la posizione di chi osserva quel contenuto, perché cosa cavolo pensate di poter vedere da un display da 6", sotto il sole cocente di una domenica di settembre, mentre camminate tra la folla di una fiera dell'elettronica di consumo? Magari a casa, al buio, con un TV o un videoproiettore di qualità, perfettamente calibrato, osservato da una distanza corretta, abbiamo qualche possibilità in più di avvicinarci a quello che intendevano i creatori di quel contenuto, soprattutto quello che ha visto il colorist mentre finalizzava il lavoro, mentre al suo fianco magari c'erano il direttore della fotografia, il regista e il responsabile della produzione.

Con questa premessa dividerò i segnali video in due grandi gruppi, senza distinzione di risoluzione, frequenza o tipologia: sono quelli con gamma dinamica standard, alias SDR (sarebbe meglio dire "compressa") con quantizzazione a 8 bit per componente (256 diversi livelli possibili) e che ne rappresentano la maggior quantità disponibile. Poi ci sono quelli a gamma dinamica elevata, alias HDR. con quantizzazione a 10 bit per componente (in teoria fino a 1024 diversi livelli, quattro volte tanto rispetto agli 8 bit dei segnali SDR).

La compressione della gamma dinamica

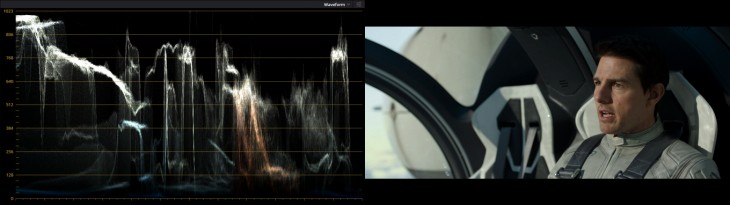

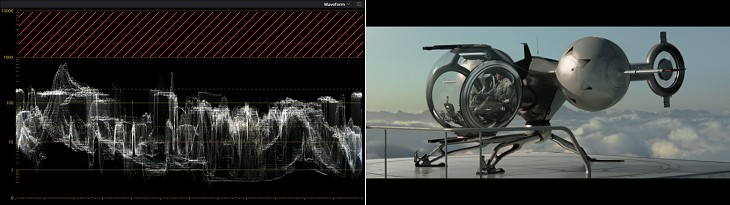

Un'immagine dai primi istanti del film Oblivion, con gamma dinamica elevata;

a sinistra il waveform, il grafico dei segnali di luminanza che sfruttano tutta la dinamica

- click per ingrandire -

Il segnale video più diffuso via etere e via streaming, segue le raccomandazioni dello standard televisivo dell'alta definizione - il notorio REC BT.709 - e si basa su un segnale digitale cosiddetto "component" (a componenti separate) con quantizzazione ad 8 bit per componente, quindi in teoria con 256 diversi livelli per componente, da zero a 255. In realtà per convenzione il livello del nero viene posizionato al valore 16 e il picco del bianco invece arriva al valore 235 per un numero complessivo di 220 diversi livelli. Per completezza, giova ricordare che nel mondo dei computer il segnale video creato dalla scheda video è di tipo RGB: quando questo è ad 8 bit per componente, il livello del nero è a zero e il picco del bianco a 255. Il limite del nero a 16 e del bianco a 235 si riferisce solo alle sorgenti video televisive, che siano decoder DVB-T, DVB-S, lettori Blu-ray Disc, DVD, streamer o altre diavolerie del genere poiché è proprio il contenuto che viene codificato con questi limiti.

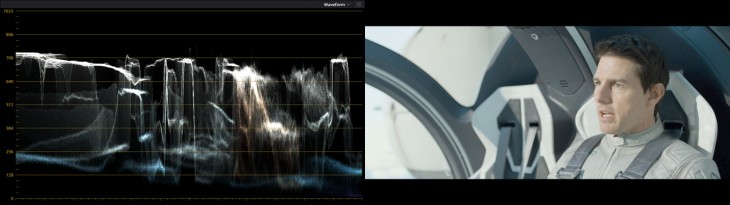

La stessa immagine dal film Oblivion, stavolta in una edizione SDR;

sempre a sinistra il waveform dei segnali di luminanza (Y) con dinamica più limitata

- click per ingrandire -

I segnali video SDR sono come quelli audio trasmessi alla radio e subiscono spesso una drammatica compressione della gamma dinamica che ne appiattisce e uniforma il volume: i bassi livelli vengono alzati e quelli più alti vengono abbassati. Tutto suona forte ma non troppo, in modo da riuscire a sentire i "pianissimo" di un concerto di musica classica anche in macchina, senza che quei mefitici altoparlanti di serie, con cestello di plastica e membrana in cartone pressato, vadano subito in distorsione. Il video SDR segue la stessa filosofia: la gamma dinamica viene compressa così tanto che riusciamo a vedere tutto quello che è stato catturato dalla videocamera o dalla cinepresa (o quasi) anche in condizioni non proprio ideali, quindi con un TV non particolarmente luminoso e/o quando c'è tanta luce in ambiente. Questo è anche un retaggio del passato e delle raccomandazioni REC BT.709. Sì, proprio quelle dell'alta definizione, che prevedono si debba vedere bene un contenuto HD anche su un TV che arrivi ad appena 100 candele su metro quadrato. Inoltre i 220 livelli a disposizione del segnale video digitale SDR sono pochi e comprimere la gamma dinamica evita anche alcuni artefatti come solarizzazioni o color bending.

Con il video SDR tutto è relativo

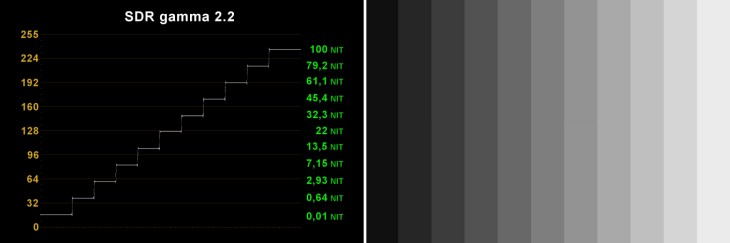

Scala dei grigi in SDR con gamma 2.2; a sinistra il waveform acquisito con DaVinci Resolve

- click per ingrandire -

Da qualche anno, anche i TV più economici sono decisamente più luminosi di 100 candele su metro quadrato (da qui in avanti li chiameremo NIT). Ormai, tranne qualche rarissima eccezione, magari scovata in qualche offerta volantino con marchio non proprio conosciutissimo, il minimo sindacale della massima luminanza di un TV entry level è di 300 NIT. Però attenzione: dal punto di vista percettivo, 300 NIT non sono tre volte di più di 100 NIT ma appena un terzo in più. Vi basti pensare che 500 NIT dal punto di vista percettivo sono più o meno il doppio di 100 NIT. Questo perché il nostro sistema visivo, costituito da occhi e cervello, funziona in maniera un po' particolare. Non è certo questa la sede di un approfondimento di fisiologia ma tenete comunque presente questa regola: un'area di uno schermo uniforme che misura 5.000 NIT sarà percettivamente più o meno il doppio rispetto ad una stessa area, identica per dimensioni e uniformità che misura 1.000 NIT.

Nell'ecosistema della riproduzione dei contenuti SDR, tutto è relativo. Non importa quanto sia luminoso il TV: la proporzione dei vari livelli di segnale e il rapporto tra livelli del segnale in ingresso e luminanza riprodotta dallo schermo, è solo relativa. Per essere espliciti, la percezione soggettiva dei contenuti video, osservata al buio con un TV che arriva al massimo a 100 NIT di picco, sarà molto simile a quella osservata con un TV da 300 NIT di picco, ammesso che siano tarati con lo stesso bilanciamento del bianco, stessi colori e stessa curva del gamma. Questo perché al buio i nostri occhi si adattano e senza riferimenti sarà difficile capire quali e quante siamo le differenze, anche quelle in termini di potenza luminosa assoluta.

La gamma dinamica HDR

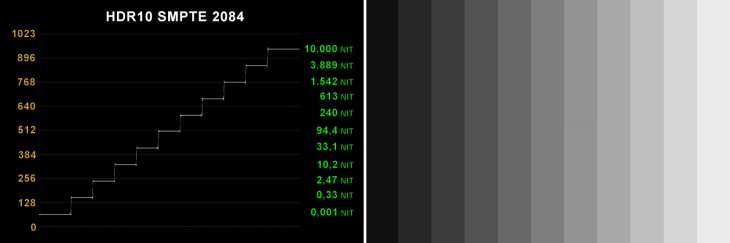

Scala dei grigi in HDR con EOTF PQ; a sinistra il waveform acquisito con DaVinci Resolve

- click per ingrandire -

Grazie alle evoluzioni tecnologiche che sono arrivate in questi ultimi anni nei TV e nella produzione dei contenuti, con l'arrivo del video HDR è cambiato tutto. Sono cambiate tante cose ma soprattutto è aumentata la capacità di riprodurre colori più saturi - colori che fino a poco fa erano visibili solo nei cinema con proiettori digitali - ed è aumentata soprattutto la massima luminanza dei TV che arrivano ormai a migliaia di NIT e non più solo ad alcune centinaia. Però sono anche cambiati i riferimenti. Se prima era tutto relativo e un "grigio" al 50% era solo riferito al massimo picco di luminanza che quel TV era in grado di riprodurre, con i segnali video HDR il "grigio" al 50% DEVE avere un suo livello di luminanza ben preciso che equivale a circa 94 NIT. Le raccomandazioni dello standard televisivo HDR sono precise e inequivocabili: la progressione dei livelli della scala dei grigi è legata a valori di luminanza ben precisi e tutti i TV dovrebbero adeguarsi, per arrivare fino ad un picco di luminanza di ben 10.000 NIT (che percettivamente sono solo il doppio di 2.000 NIT).

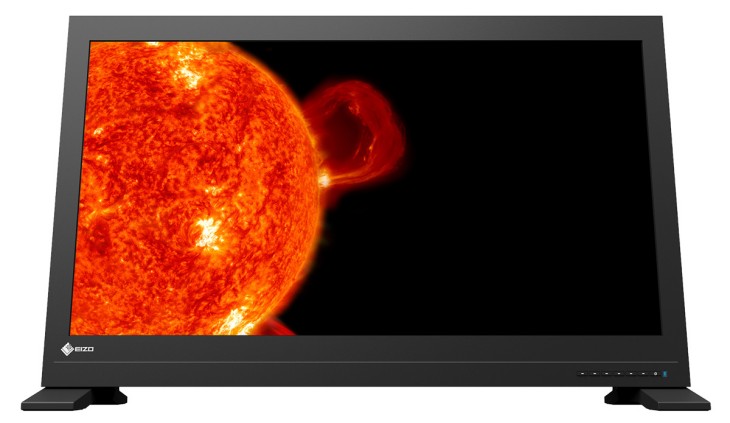

La maggior parte dei film HDR viene preparata e controllata in post produzione attraverso monitor di riferimento, spesso con picco di luminanza di 1.000 NIT, e con rapporto di contrasto nativo elevatissimo, come l'EIZO CG3145 di cui potete leggere in questo test. Talvolta vengono usati anche monitor più luminosi, fino a 4.000 NIT. In rare eccezioni si va anche oltre. Ebbene, le informazioni sulla luminanza di quei contenuti HDR sono allocate nei bit, nei livelli del segnale video digitale, esattamente come succede per i segnali SDR. Nei segnali HDR si passa però a 10 bit per componente cromatica, quindi a 1024 diversi valori - almeno in teoria - e vedremo tra poco perché avere quattro volte più sfumature rispetto ai segnali SDR sia così importante. C'è però un limite: anche in questo caso il livello del nero non è a zero ma è posto al livello 64 (quattro volte il livello 16 dei segnali SDR) mentre il massimo livello possibile del bianco, pari a 10.000 NIT, è posto al livello 940 (quattro volte il livello 235). I livelli possibili del segnale video HDR10 sono 877 e non 1024.

Fotogramma dall'edizione UHD Blu-ray 4K in HDR di Oblivion con waveform;

la zona oltre il limite dei 1.000 NIT non usata è tratteggiata in rosso

- click per ingrandire -

C'è poi un ulteriore limite nel segnale video HDR più diffuso che è quello HDR10. Come già anticipato la maggior parte dei contenuti HDR viene preparato e controllato attraverso monitor che arrivano fino a 1.000 NIT di picco di luminanza, limite che nella scala a 10 bit si trova più o meno al livello 723 su 1024 possibili valori (da 0 a 1023). Approfitto per sottolineare che il livello 789 corrisponde a circa 2.000 NIT, il livello 855 corrisponde a circa 4000 NIT e così via fino al massimo dei 10.000 NIT che corrispondono al livello 940. Quindi, la maggior parte dei contenuti HDR che non prevedono informazioni oltre il picco di 1.000 NIT di luminanza, non sfruttano tutto lo "spazio" a disposizione nel segnale digitale ma solo l'intervallo compreso tra il livello 64 e il livello 723, ergo circa il 65% di tutto lo spazio a disposizione. Alcuni film, pochissimi per fortuna, si fermano addirittura molto prima.

Il Tone Mapping con metadati statici

Monitor di riferimento EIZO CG3146 da 1.000 NIT testato in questo articolo

- click per ingrandire -

Ora ipotizziamo che avete il vostro contenuto HDR, magari confezionato in un Blu-ray Disc 4K dal bit-rate elevatissimo, con segnali che non vanno oltre il picco di luminanza di 1.000 NIT, anche perchè il suddetto film è stato preparato e controllato su un monitor di riferimento con quelle precise catatteristiche, quindi picco del bianco di 1.000 NIT e livello del nero ben al di sotto del valore di 0,001 NIT, quindi con rapporto di contrasto di un milione a uno. Vi apprestate quindi a visionare questo film da Blu-ray DIsc 4K HDR, attraverso un lettore al di sopra di ogni sospetto, con il vostro TV consumer che, per quanto spettacolare possa essere, non è detto che arrivi alle prestazioni del monitor utilizzato per la post-produzione e che, per la cronaca, costa non meno di 30.000 euro, tasse escluse.

Magari il vostroTV non arriva allo stesso picco di luminanza, oppure ha un livello del nero sensibilmente più elevato, oppure ancora ha un gamut che magari è quasi perfetto ma la precisione nella riproduzione dei colori più saturi sulle basse luci magari non è poi così precisa. Insomma è un casotto infernale e non si salvano neanche i TV di fascia più alta, come spesso vi segnaliamo nei nostri test approfonditi su AV Magazine. Quando si tratta di HDR, il vostro povero TV è costretto spesso a operare vari compromessi. Si inizia con una compressione della gamma dinamica e vengono modificati tinta, livello e saturazione dei colori, cercando di mediare tra quello che sarebbe il riferimento che ha visto il colorist sul monitor da 30.000 euro e le possibilità del "ferro" che vi ritrovate in soggiorno.

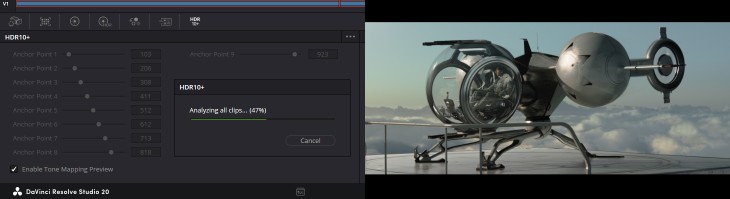

Analisi dei metadati statici con DaVinci Resolve 20

- click per ingrandire -

Ecco quindi che, per aiutare la riproduzione dei contenuti HDR, nei TV e nei videoproiettori consumer, ai segnali video HDR sono associati dei metadati statici. Quando sono presenti - non è detto che lo siano sempre - si riferiscono solo alle caratteristiche del monitor usato nella post produzione (livello del nero, picco del bianco e le tre coordinate del gamut colore) assieme a due altri valori statistici, misurati dopo aver analizzato tutto il contenuto, dal primo all'ultimo secondo: il massimo livello di luminanza (alias MaxCLL) e la media dei valori di luminanza (alias MaxFALL), indicati entrambi in NIT, ovvero in candele su metro quadrato. Alcune volte questi dati sono errati. Molto più spesso di quanto pensiate sono addirittura fuorvianti e invece che aiutare il TV creano ancora più problemi. L'obiettivo però è chiaro: fornire dei metadati che possano aiutare il TV o il proiettore ad effettuare quella operazione che viene descritta come Tone Mapping, ovvero adattamento della dinamica e dei colori alle possibilità del display che viene utilizzato per la riproduzione.

Metadati dinamici e processori video dedicati

I tre processori video più interessanti, analizzati e messi a confronto in questo articolo

- click per ingrandire -

Per fortuna, esiste una seconda strada che prevede la presenza di metadati dinamici, inseriti direttamente da chi ha lavorato alla post produzione dei contenuti. In questi metadati ci sono molti più elementi statistici che dovrebbero aiutare l'elettronica dei TV e dei videoproiettori a trovare il miglior compromesso per riprodurre i contenuti HDR senza allontanarsi troppo dalle intenzioni di cui quel contenuto lo ha preparato e verificato osservandolo da un monitor di riferimento. I due sistemi con metadati dinamici consumer più diffusi sono HDR10+ e Dolby Vision, con quest'ultimo che ha il grande vantaggio di poter sfruttare sempre l'intera gamma dinamica del segnale. Vi ricordate il limite che vi ho indicato prima, con il picco di luminanza di 1.000 NIT legato al valore 723 e allo "spreco" di spazio digitale da qui al livello 940? Con il Dolby Vision questo non succederebbe e verrebbe sfruttato sempre tutto lo spazio a disposizione, partendo addirittura da zero e non da 64, tanto poi ci sono i metadati dinamici a dire al TV qual è il picco di luminanza, scena per scena.

Per migliorare la riproduzione dei contenuti HDR su TV e proiettori non ci sono i metadati dinamici ma c'è anche una terza via: l'analisi del segnale video in riproduzione, fotogramma per fotogramma, pixel per pixel, direttamente dall'elettronica del TV, del proiettore o di un processore video dedicato, con la produzione di elementi statistici ben più sofisticati anche rispetto al miglior sistema con metadati dinamici. Ci sono processori video molto sofisticati, usati in quei campi in cui è necessaria una compressione della gamma dinamica ben più pesante e delicata di quella necessaria nei TV. Mi riferisco al settore della videoproiezione di fascia alta, dove il picco di luminanza è di 100 NIT o poco superiore e non di 1.000 come quello di un TV in questo caso il costo del solo processore video che opera analisi ed elaborazioni in tempo reale parte da qualche migliaio di euro e può arrivare a sfiorare i 20.000 euro, iva e installazione incluse. Maggiori info in questo approfondimento.

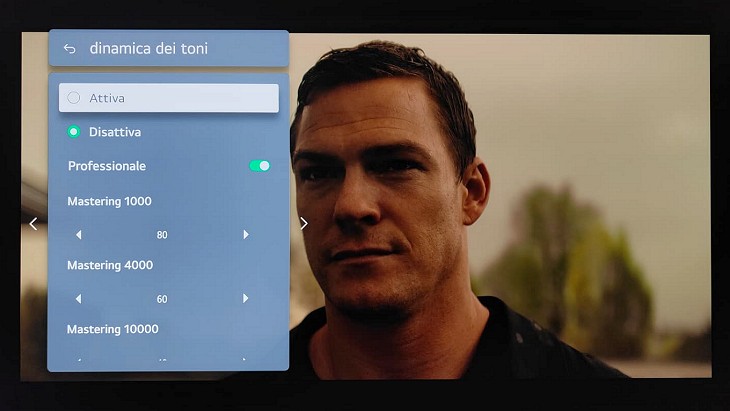

Il menu per le impostazioni del tone mapping nei TV LGE di ultima generazione

- click per ingrandire -

Per un TV però non serve necessariamente spendere queste cifre perché, per le analisi statistiche sul segnale e le conseguenti elaborazioni per adattare i contenuti HDR alle possibilità dei TV e dei proiettori, ha raggiunto un livello di sofisticazione, potenza e accuratezza, sorprendente anche per chi, come me, è abituato a processori video dedicati di cui sopra. Però, anche nel caso del miglior sistema di analisi sul segnale HDR presente in un TV, quello che manca spesso è l'uso che si fa di queste informazioni e il risultato finale, ovvero l'adattamento e la vicinanza della riproduzione all'agognato riferimento usato nella post-produzione. Del resto è proprio vero che "non c'è potenza senza controllo" (cit.)..

Ebbene il Dolby Vision si propone proprio questo nobile obiettivo: fornire all'elettronica del TV o del proiettore prima di tutto un segnale video della migliore qualità possibile, assieme a tutti quei metadati dinamici necessari per agevolare tutte le elaborazioni e per trovare il miglior compromesso possibile per non allontanarsi troppo dalle intenzioni dei creatori dei contenuti. In questi primi otto anni di Dolby Vision il mio personale bilancio non è poi così positivo, spesso a causa delle implementazioni che troviamo nei TV o della eccessiva complicazione del sistema che ne ha reso impossibile la sua piena implementazione praticamente con nessun lettore Blu-ray Disc. Solo oggi, con gli ultimi player dotati del pregevole SoC Amlogic come il mio fido Dune HD 8K riesco a sfruttare al meglio un file HDR in Dolby Vision. Ma questa è un'altra storia...

Tutte le novità del Dolby Vision 2

L'ingresso della suite Dolby all'IFA di Berlino

- click per ingrandire -

Ecco quindi arrivati a Berlino e all'annuncio del Dolby Vision 2, un nuovo ecosistema che all'inizio è stato sviluppato in collaborazione con Mediatek, Hisense e anche alcune piattaforme di distribuzione. Dopo l'annuncio, mentre ero ad IFA, sono andato subito da Dolby per osservare da vicino le novità e anche per fare qualche domanda. Oltre che indicarvi la news pubblicata a questo indirizzo, approfitto per un breve riassunto. La prima novità che arriverà con il nuovo Dolby Vision 2 è la presenza di due versioni distinte, anche se i metadati presenti nei flussi dati del nuovo Dolby Vision 2 saranno solo di un tipo, oltre che retro-compatibili con TV e proiettori dotati dell'attuale versione. Secondo le informazioni fornite, la compilazione dei metadati del Dolby Vision 2 avrà anche il sostegno dell'intelligenza artificiale, per facilitare e completare il compito di chi preparerà i contenuti.

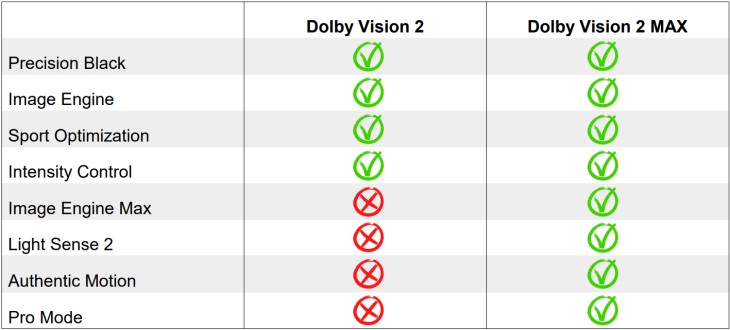

Differenze tra le due versioni del Dolby Vision 2 a seconda del TV

- click per ingrandire -

La differenza tra Dolby Vision e Dolby Vision 2 Max sarà solo lato TV. La versione "standard" dei TV più economici sfrutterà solo parte dei nuovi metadati mentre quella "MAX" permetterà in teoria un tone mapping ancora più sofisticato, la gestione dell'interpolazione dei fotogrammi e sfrutterà i sensori di illuminanza per adeguare le elaborazioni alle condizioni di visione, un po' come già avviene con il Dolby Vision IQ, con direttive che stavolta saranno inserite nei metadati. Tutti i TV utilizzati nelle dimostrazioni erano Hisense, alcuni con il nuovo SoC Pentonic 800. Dolby ci ha spiegato che l'implementazione in altri SoC è possibile. Al momento non è prevista la compatibilità con i videoproiettori. Del resto non era prevista neanche con la prima versione del 2014...

Image Engine, Precision Black e Light Sense 2

Aaron Dew, Senior Product Manager Home Devices, Dolby Laboratories

- click per ingrandire -

Ecco invece l'analisi di tutte le novità annunciate, una per una, iniziando dall'Image Engine che dovrebbe essere simile come concetto alla prima versione del Dolby Vision e che contiene la maggior parte dei metadati dinamici per l'elaborazione di un tone mapping più preciso possibile. Questi dati saranno sfruttati a dovere solo nei TV di fascia più elevata, quindi con la versione Image Engine MAX. C'è chi ipotizza che l'Image Engine sia il nucleo dei metadati del primo Dolby Vision mentre il nuovo motore "MAX" porti con sé qualche elemento in più. Altri sostengono che sia solo marketing. Stavolta grazie all'Image Engine Max il tone mapping del TV potrà sfruttare il picco di luminanza magari superiore al monitor usato nella post produzione, situazione in cui entrerò nel dettaglio nelle conclusioni, più avanti.

La funzione forse più interessante è il Precision Black, disponibile anche con la versione base del Dolby Vision 2, che andrebbe ad inserire nei metadati un numero di informazioni per la gestione delle basse luci che dovrebbe essere più elevato rispetto all'attuale Dolby Vision, assieme ad un dato che a me sembra francamente inutile: il livello di illuminanza presente nello studio di correzione colore, che di norma dovrebbe essere pari a zero. Nella versione Max il Precision Black lavora in sinergia anche con il Light Sense 2 che utilizzerà la misura dei lux (forse anche del "colore") della luce in ambiente dove è posto il TV, per raggiungere il miglior compromesso. La funzione Light Sense 2 sarà disponibile solo nei TV compatibili Dolby Vision 2 MAX.

Intensity Control e Sport Optimization

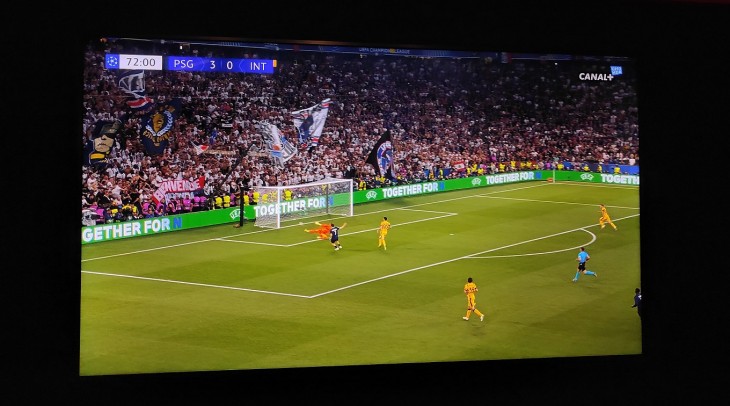

Una partita di calcio in Dolby Vision 2 con funzione "Intensity Control" attivata

- click per ingrandire -

Poi c'è la funzione chiamata Intensity Control, anche questa presente nel Dolby Vision 2 "base". Si tratta di una voce del menu utente, richiamabile velocemente, in cui è possibile modulare l'intensità dell'immagine, intesa come mix di luminanza complessiva, contrasto e colori. In pratica si dà all'utente finale un solo e semplice controllo per rendere le immagini più luminose, senza snaturarne l'equilibrio che è stato deciso in fase di produzione. Abbiamo verificato questa funzione, nella forma di uno "slider" verticale, solo con immagini sportive e non c'è dubbio che funzioni molto bene. La funzione Sport Optimization apre la possibilità a chi distribuisce i contenuti di cambiare alcuni parametri del TV come bilanciamento del bianco, gamma e riproduzione dei colori, in modo da rendere le immagini più "accattivanti" per l'utente finale. Mentre un brivido mi correva dietro la schiena, ho fatto la mia prima domanda a Thomas Graham, Head of Dolby Vision Content Enablement: nella mia esperienza di calibratore professionale, all'interno di una regia televisiva sportiva HDR, mi si chiede di calibrare tutti i monitor su standard ben precisi, quindi sul bianco D65 e sui relativi colori. Mi sono distratto ed è cambiato qualcosa?

Thomas Graham ha messo subito le mani avanti: non è cambiato nulla, il bilanciamento del bianco di riferimento è ancora il D65 e il controllo della produzione di eventi sportivi viene ancora effettuato su monitor calibrati secondo i riferimenti classici. Viene solo data la possibilità, al distributore dei contenuti (e non al creatore da quello che ho potuto capire), di modificare alcuni parametri per allontanare letteralmente l'immagine dal riferimento, in modo da renderla più accattivante, più "ruffiana", ovvero quello che si aspetta lo spettatore. Nella dimostrazione a cui ho assistito, durante la visione di una piccola clip di una partita di calcio, la modifica del bilanciamento del bianco era sottile ma percepibile e leggermente più "fredda", colorata e contrastata come equilibrio cromatico. Si tratta di una funzione che può essere disattivata dall'utente finale ma è proprio il principio che mi sembra anacronistico: Dolby che prima era quasi come un "fortino" che dava strumenti ai creatori di contenuti per difendere le loro volontà, ora va nella direzione opposta…

Authentic Motion e Pro Mode

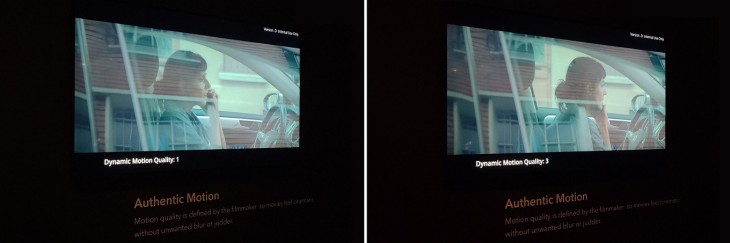

Confronto tra due delle modalità "Authentic Motion"

- click per ingrandire -

Veniamo ora alla funzione che, da buon "integralista" del rispetto delle intenzioni dei creativi, mi ha fatto letteralmente saltare sulla sedia: Authentic Motion, alias interpolazione dei fotogrammi. Con il Dolby Vision 2 MAX, il creatore dei contenuti consente che vengano creati dei fotogrammi intermedi, anche soltanto su alcune scene; può farlo inoltre su 5 diversi livelli. Se il frame-rate originale è di 24 fps, il pannello di alcuni TV può arrivare fino ad almeno 120Hz e in alcuni casi anche a 240 Hz, ecco quindi che c'è molto spazio per inventarsi vari livelli di interpolazione, più o meno invasivi, tutti elaborati dal processore interno al TV. Non c'è dubbio che in alcuni film, soprattutto in alcune scene, il tempo di otturazione della macchina da presa è troppo breve, i fotogrammi troppo nitidi e i movimenti che vengono catturati troppo rapidi (come in un carrello orizzontale). In queste occasioni l'incedere a scatti delle immagini 24p diventa in effetti fastidioso e rischia di distrarre lo spettatore. Si tratta di errori di produzione, come il famigerato panning verticale sull'autostrada delle macchine in fila nel film "Sicario" o il lungo carrello orizzontale ne "L'ora più buia".

La famigerata sequenza dal film Sicario

- click per ingrandire -

In questo caso è il creatore dei contenuti che consente l'attivazione di una interpolazione dei fotogrammi, anche blanda, per recuperare parzialmente agli errori commessi. Da questo punto di vista, è una possibilità che, se sfruttata a dovere, potrebbe anche essere utile. Io rimango molto scettico e ho qualche dubbio su quanti film potranno utilizzare questa funzione e tra questi quanti lo faranno senza snaturare il messaggio originale. Nella dimostrazione presso la sala Dolby, l'intervento dell'interpolazione nella clip selezionata era in effetti discreto e accettabile e senza artefatti apprezzabili, fino al livello 2 su 5. Oltre, secondo me, l'effetto soap-opera diventa troppo evidente, per non parlare degli artefatti. Veniamo ora all'ultima "follia", ovvero al tone mapping permesso dal Dolby Vision 2 Max che può sfruttare i valori di luminanza dei nuovi TV che in alcuni casi arriveranno addirittura a sfiorare i 10.000 NIT, In particolare il grande TV Hisense in dimostrazione, aveva un picco di luminanza superiore ai 6.000 NIT.

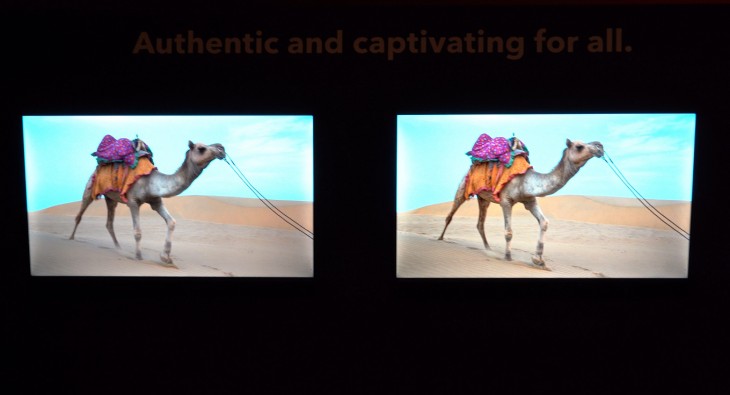

Picco di luminanza altissimo (superiore ai 5.000 NIT) che copre i dettagli

nelle basse luci, altrimenti visibili con luminanza adeguata (1.000 NIT)

- click per ingrandire -

Anche quando il contenuto fosse limitato ad un picco di luminaza di 1.000 NIT, con il Dolby Vision 2 Max è possibile lasciare al TV la possibilità di scalare il livello di luminanza per sfruttare tutta la potenza a disposizione. In quali casi? Ad esempio quando c'è luce in ambiente. E fin qui, anche se dovrebbe essere "proibito" guardare film HDR in ambienti illuminati, non mi sento di censurare questa possibilità, comunque già disponibile in parte con Dolby Vision IQ che invece mi lascia più perplesso è la possibilità di scalare picchi di luminanza molto più elevati rispetto al riferimento, anche quando si è in un ambiente oscurato, con il risultato di abbagliare gli occhi dello spettatore, rendendo ancora più difficile la percezione dei particolari sulle basse luci che a quel punto andrebbero rimodulate, mentre per i display con local dimming dal numero di zone più limitato, gli aloni diventerebbero ancora più evidenti. Rimane infine la funzione Pro Mode che non è stata ancora svelata nel dettaglio e su cui torneremo in un secondo momento.

Conclusioni

La bravura di Dolby nell'inventarsi nuovi modi per mettere in movimento dei soldi nel settore dell'intrattenimento è davvero leggendaria e spesso porta con sé anche molti benefici per l'utente finale. Non c'è dubbio che sulla carta il Dolby Vision 2 abbia alcune novità che sono interessanti, come il "Precision Black" oppure "Intensity Control". Sono molto più scettico sulle funzioni come Authentic Motion e Sport Optimization, che sembrano andare nella direzione opposta rispetto alle intenzioni di chi ha creato i contenuti. In realtà la modalità "Authentic Motion" potrebbe aprire nuovi scenari in una strada già tracciata dall'ultimo Avatar che nella versione stereoscopica ha sfruttato frame-rate diversi, tra 24p e 48p, per aumentare la fluidità nelle scene con movimenti più concitati. Con Authentic Mode, Dolby potrebbe inserire questa possibilità ex-post, sfruttando l'elaborazione del SoC Pentonic e in futuro anche di altri processori.

Il Dolby Vision 2 (a destra) a confronto tra TV "entry" con luminanza di 300 NIT

- click per ingrandire -

Concludo rivolgendomi a tutti quelli che sono preoccupati della eventualità di "ricomprare" tutti i TV, per garantirsi la compatibilità con il Dolby Vision 2. La storia recente ci ha insegnato che per l'implementazione di un nuovo sistema, specialmente così complesso come il Dolby Vision 2, servirà molto tempo. Magari non servirà più di un lustro come accaduto per il primo Dolby Vision ma sarà difficile vedere qualcosa di fruibile prima della fine del 2026. Nel frattempo bisognerà capire quali aziende saranno disposte ad investire denaro per implementare il Dolby Vision 2, quanti saranno i servizi di streaming che lo adotteranno e quali saranno i contenuti, contando che per necessità di marketing Dolby potrebbe anche accollarsi la ricodifica di qualche film iconico. A quel punto andrà verificata anche la compatibilità di alcune sorgenti, come gli ultimi media player e streamer stand alone, per poter alla fine preparare uno shoot-out, magari con due TV tarati talmente bene da sembrare identici, per verificare la superiorità di questo nuovo Dolby Vision 2 anche rispetto all'elaborazione integrata nel TV. Quando arriverà questa possibilità sono certo che ci divertiremo tantissimo. Scommettiamo?

Per gli approfondimenti, vi rimando agli articoli correlati più in basso, dopo il sommario.

SOMMARIO

- C'era una volta il Dolby Vision...

- Qualità video: segnali SDR vs. HDR

- La compressione della gamma dinamica

- Con il video SDR tutto è relativo

- La gamma dinamica HDR

- Il Tone Mapping con metadati statici

- Metadati dinamici e processori video dedicati

- Tutte le novità del Dolby Vision 2

- Image Engine, Precision Black e Light Sense 2

- Intensity Control e Sport Optimization

- Authentic Motion e Pro Mode

- Conclusioni

Vietata la copia e la distribuzione (anche parziale) senza la previa autorizzazione di AV Raw s.n.c.

Per maggiori informazioni : https://www.avmagazine.it/sito/legale/

Copyright 2005 - 2026 AV Magazine

AV Magazine - registrazione Tribunale di Teramo n. 527 del 22.12.2004

Direttore Responsabile: Emidio Frattaroli